[ad_1]

De nos jours, le succès des petites ou grandes organisations dépend en grande partie d’Internet. Pour communiquer et interagir avec leurs clients, ces entreprises utilisent Internet. Toutes ces tâches nécessitent l’utilisation d’outils de grattage en ligne, tels que les outils de grattage Web Python, pour accéder aux données pertinentes.

En raison de l’énorme augmentation de la demande de technologie, les données sont devenues un élément essentiel de la vie moderne. Vous aurez toujours besoin de collecter des données sur les problèmes liés à votre entreprise, quel que soit le type d’entreprise que vous dirigez. Cependant, à moins que vous ne disposiez d’un outil de grattage Web Python, le grattage des données n’est pas une tâche simple.

Vous souhaitez en savoir plus sur le web scraping et les technologies qui y sont utilisées ? Ne cherchez nulle part ailleurs. Vous pouvez tout trouver dans cet article.

1. ScraperAPI

Un outil pour créer des scrapers Web est ScraperAPI. Avec une seule requête API, l’API scraper gère les proxies, les navigateurs et le captcha pour obtenir du HTML brut à partir de n’importe quel site Web. Il limite automatiquement les requêtes pour échapper aux blocages IP et aux captchas tout en gérant son propre pool interne de milliers de proxys provenant de divers fournisseurs de proxy.

Il s’agit du meilleur service de grattage en ligne disponible, avec des pools de proxy uniques pour le grattage des prix du commerce électronique, le grattage des moteurs de recherche, le grattage des médias sociaux, le grattage des baskets, le grattage des billets, etc.

2. ScrapingBee

Avec l’aide de l’API de scraping Web ScrapingBee, vous pouvez naviguer sur Internet sans être arrêté. Nous fournissons à la fois des proxys standard (centre de données) et premium (résidentiels) afin que vous ne soyez plus jamais interdit de scraper en ligne.

De plus, nous vous offrons la possibilité d’afficher toutes les pages dans un vrai navigateur (Chrome), ce qui nous permet de prendre en charge les sites Web qui reposent de manière significative sur JavaScript.

Pour les développeurs et les entreprises informatiques qui souhaitent gérer directement le processus de grattage sans avoir à se soucier des proxies et des navigateurs sans tête, il existe ScrapingBee.

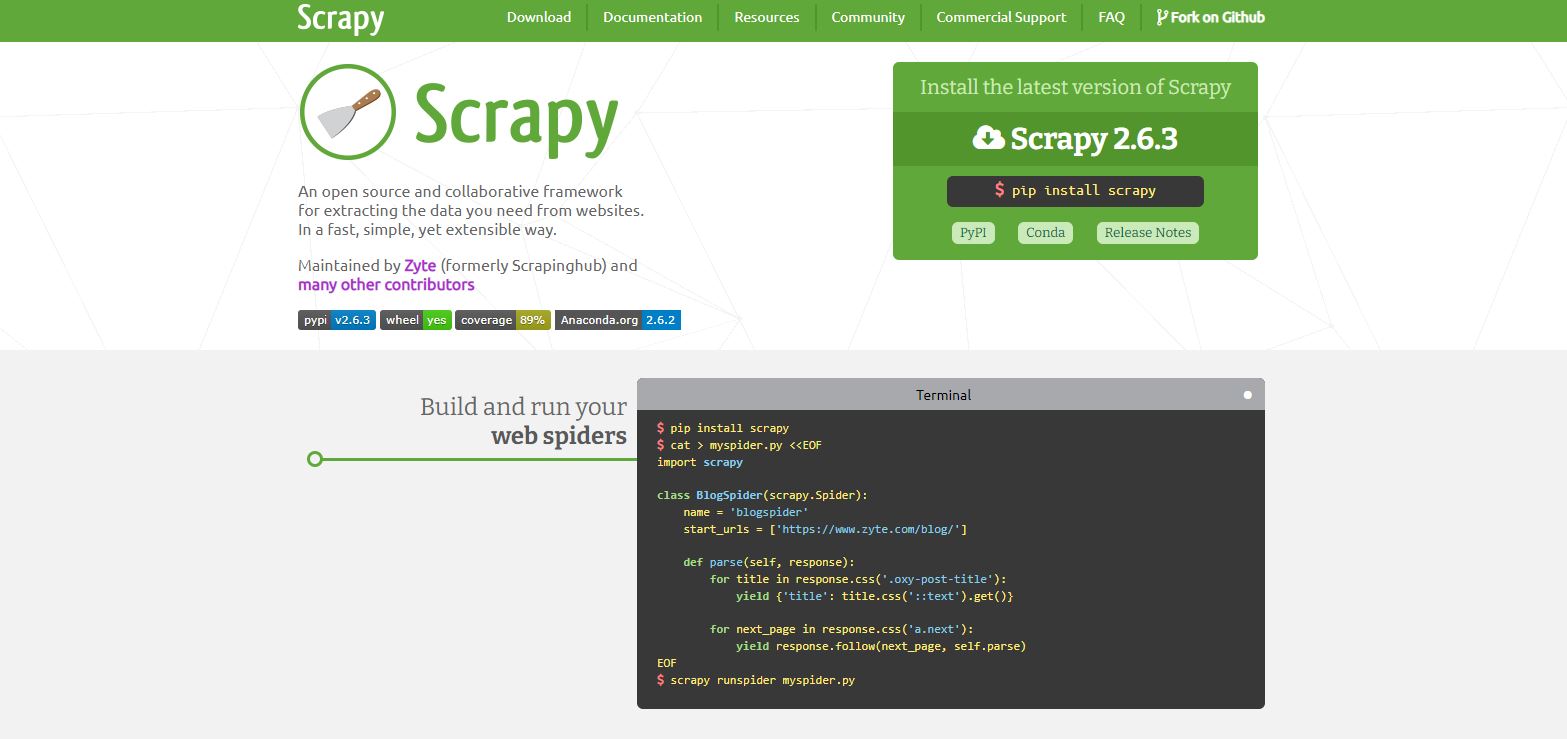

3. Scrapy

Pour les développeurs Python, Scrapy est un framework d’exploration et de grattage Web. Parce que Scrapy est un framework complet, il comprend tous les outils nécessaires au web scraping, comme un module pour effectuer des requêtes HTTP et extraire des données de la page HTML téléchargée.

Il est libre d’utilisation et open-source. Les données peuvent également être sauvegardées par grattage. Cependant, Scrapy est incapable d’afficher JavaScript et doit donc utiliser une autre bibliothèque. Pour cela, vous pouvez utiliser Splash ou le célèbre outil d’automatisation de navigateur Selenium.

4. Dexi.io

Dexi.io (anciennement cloudscape) rassemble des informations à partir d’un site Web sans avoir besoin de téléchargements comme d’autres services. Il permet aux utilisateurs de configurer des robots d’exploration et de récupérer des données en temps réel à l’aide d’un éditeur basé sur un navigateur.

Les données récupérées peuvent être exportées au format CSV ou JSON ou conservées sur des services cloud tels que Google Drive et Box.net. L’accès aux données est pris en charge par Dexo.io en fournissant un certain nombre de serveurs proxy et de dissimulation d’identité. Les données sont conservées sur les serveurs de Dexo.io pendant deux semaines avant d’être archivées.

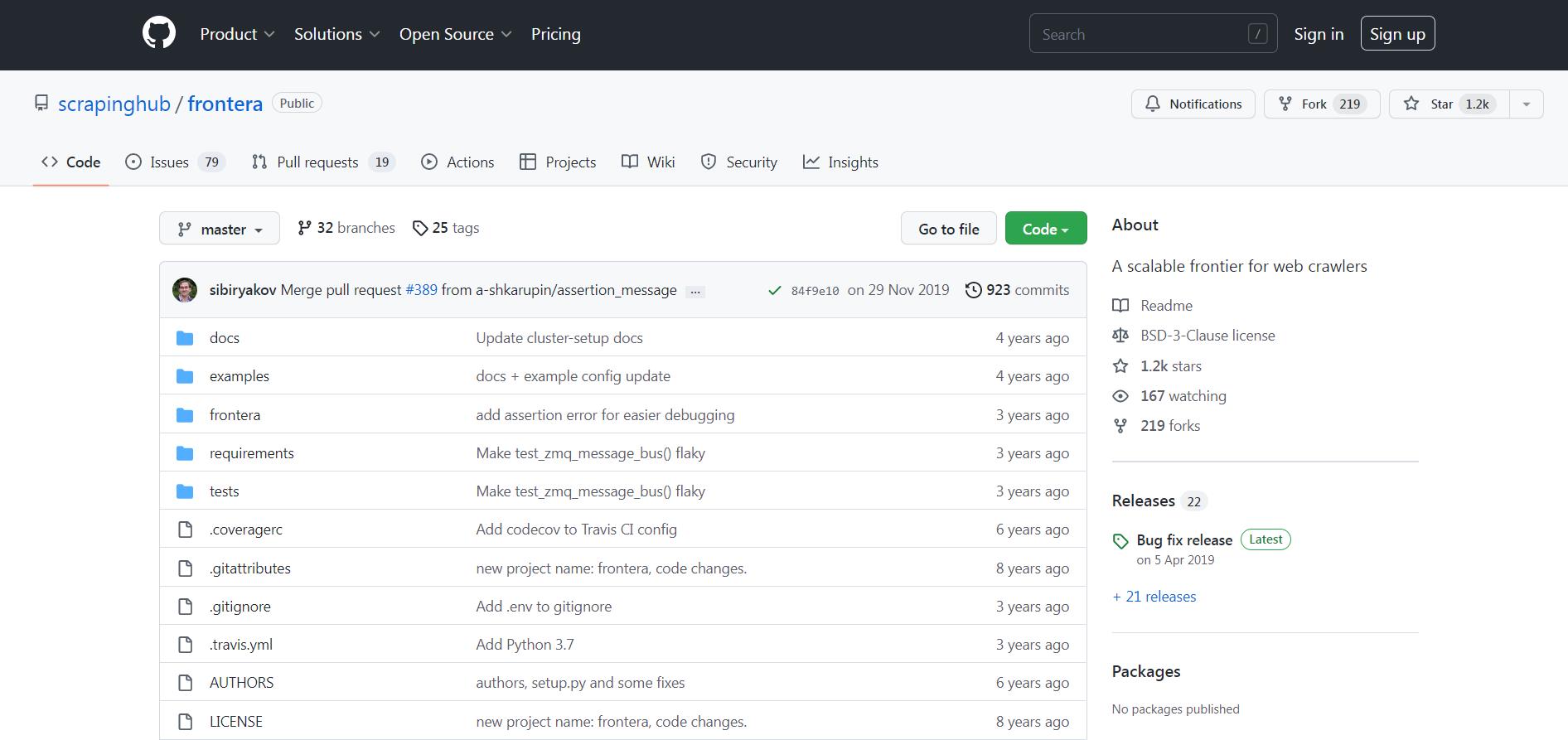

5. Frontière

Frontera est un autre outil d’exploration Web. Il s’agit d’un framework open-source conçu pour faciliter le processus de construction de la frontière d’exploration. Dans les systèmes d’exploration de plus en plus avancés, une frontière d’exploration est un système en charge de la logique et des politiques à suivre lors de l’exploration de sites Web.

Il établit des directives pour l’ordre dans lequel les pages doivent être explorées, leur priorité lors des visites, la fréquence à laquelle elles doivent être revisitées et tout autre comportement que vous pourriez souhaiter intégrer dans l’exploration.

Il est compatible avec Scrapy ainsi qu’avec tous les autres frameworks d’exploration Web. Pour les programmeurs et les entreprises informatiques qui utilisent Python, Frontera est fantastique.

6 Apifier

Tout site Web peut avoir une API créée pour lui et des données structurées extraites à l’aide de la plate-forme de grattage et d’automatisation Apify. Pour les sites Web dotés de mesures anti-scraping robustes, Apify ajoute son propre service proxy intelligent pour augmenter la fiabilité du scraping.

Apify propose des centaines de grattoirs prêts à l’emploi pour des sites Web bien connus, mais il s’agit également de solutions sur mesure abordables, simples et rapides à acheter. Toute personne sans connaissances en codage peut configurer, planifier et exécuter n’importe quel grattoir Apify, mais la plate-forme est également suffisamment robuste pour être idéale pour les développeurs chevronnés.

7. ParseHub

Le crawling d’une ou plusieurs pages web est possible avec ParseHub. De plus, ParseHub prend en charge les sessions, les cookies, AJAX, JavaScript et les redirections. ParseHub reconnaît les textes complexes sur le Web à l’aide de la technologie d’apprentissage automatique et crée des fichiers de sortie avec les formats de données nécessaires.

Sur la base des demandes des clients, ParseHub travaille pour extraire les données des sites Web et les stocker localement. Les utilisateurs de Parsehub peuvent commencer à utiliser une interface utilisateur agréable avec une assistance utilisateur de très haute qualité sans même avoir une compréhension de base de la programmation.

Les utilisateurs peuvent récupérer des données à l’aide de Parsehub pour extraire des éléments tels que des adresses e-mail, des données disparates, des adresses IP, des images, des numéros de téléphone, des prix et des données Web. Une version de bureau de ParseHub est également accessible pour Windows, Mac OS X et Linux.

8. Octoparse

Un autre outil de grattage Web avec une application de bureau est Octoparse (Windows uniquement, désolé les utilisateurs de macOS). Il ressemble beaucoup à Parsehub. Bien que le prix soit inférieur à celui de Parsehub, nous avons trouvé l’outil plus difficile à utiliser.

Vous pouvez effectuer à la fois une extraction locale et une extraction cloud (à l’aide du cloud ParseHub) (sur votre propre ordinateur). Pour : Des prix abordables. Négatif : Courbe d’apprentissage élevée uniquement pour Windows

Emballer

De plus, compte tenu de la variété d’outils à votre disposition, vous disposez d’un nombre raisonnable d’options au cas où certaines ne conviendraient pas à votre cas d’utilisation. Étant donné que les web scrapers peuvent vous aider à extraire des données de sites en ligne, vous n’avez plus aucune excuse pour éviter de les utiliser pour développer des informations.

[ad_2]

![Technologie essentielle que les agents immobiliers devraient utiliser en 2023 [Let’s Rise Real Estate Business]](https://dunouveautech.com/wp-content/uploads/2022/11/essential-tech-that-real-estate-agents-should-use-in-2023-lets-rise-real-estate-business-350x230.jpg)